Czym są roboty Google i jaki mają wpływ na pozycjonowanie? W tym artykule dowiesz się, kto jeszcze oprócz użytkowników trafia na Twoją stronę internetową i na co zwraca uwagę. Roboty Google – bo o nich mowa – odgrywają kluczową rolę w procesie indeksowania i rankingu stron internetowych. Ich działanie ma bezpośredni wpływ na to, czy i jak wysoko Twoja strona pojawia się w wynikach wyszukiwania.

Googlebot, czyli kto oprócz potencjalnych klientów odwiedza Twoją stronę

Prowadzenie swojego biznesu w internecie opiera się na dotarciu do potencjalnych klientów – to oczywistość. Jednak zadanie wydaje się proste jedynie z pozoru. Zastanawiając się nad tym, okazuje się, że jest wiele elementów, które należy wziąć pod uwagę. Od sprecyzowania grupy docelowej przez analizę zachowań użytkowników, aż po User Experience. Dodajmy do tego strategię komunikacji marki i działalność w Social Mediach…Ponadto jak się okazuje – strona internetowa powinna być dostosowana nie tylko do użytkownika?

- Googlebot to ogólna nazwa dla 2 typów robotów skanujących.

- Googlebot na smartfony – tworzy symulację użytkownika na urządzeniu mobilnym,

- Googlebot komputerowy – symuluje zachowania użytkownika na komputerze.

Są to najbardziej zaawansowane roboty indeksujące w algorytmie Google. Ich zadaniem jest zbieranie informacji o stronach internetowych, aby umożliwić tworzenie aktualnych i kompletnych indeksów, które są podstawą do wyświetlania wyników wyszukiwania. Robot indeksujący nie powinien odwiedzać strony więcej niż co kilka sekund. Podczas jednej wizyty stara się przejść po jak największej ilości stron bez obciążania serwera.

Same robot indeksujący to nic innego jak program, który służy do automatycznego znajdowania i skanowania stron internetowych poprzez przechodzenie po linkach od strony do strony.

Roboty indeksujące Google – jest ich więcej

Googlebot na smartfony i komputery to nie jedyne roboty, które przemierzają odmęty internetu. Poza nim strony internetowe odwiedzane są przez szereg innych programów. Ich celem jest skanowanie wyszukiwarki w celu indeksowania określonych usług. Wśród robotów indeksujących wyróżniamy m.in. 7 poniższych:

- Googlebot Image, który rejestruje zdjęcia;

- Googlebot News odpowiedzialny za skanowanie wszystkich informacji i wiadomości;

- Googlebot Video skanujący pliki wideo;

- Googlebot StoreBot – przechodzi przez proces płatności (od strony produktowej przez koszyk do płatności);

- Google-InspectionTool – dodany w maju 2023 r. bot zajmuje się testowaniem narzędzi używanych w m.in. Google Search Console (inspekcja URL);

- GoogleOther – jego zadaniem jest odciążenie Googlebota, przeznaczony jest to mniejszych zadań (np. indeksowanie badawczo-rozwojowe);

- Google-Extended – informuje Google o tym, czy dana strona internetowa powinna być ujęta w projektach związanych ze sztuczną inteligencją.

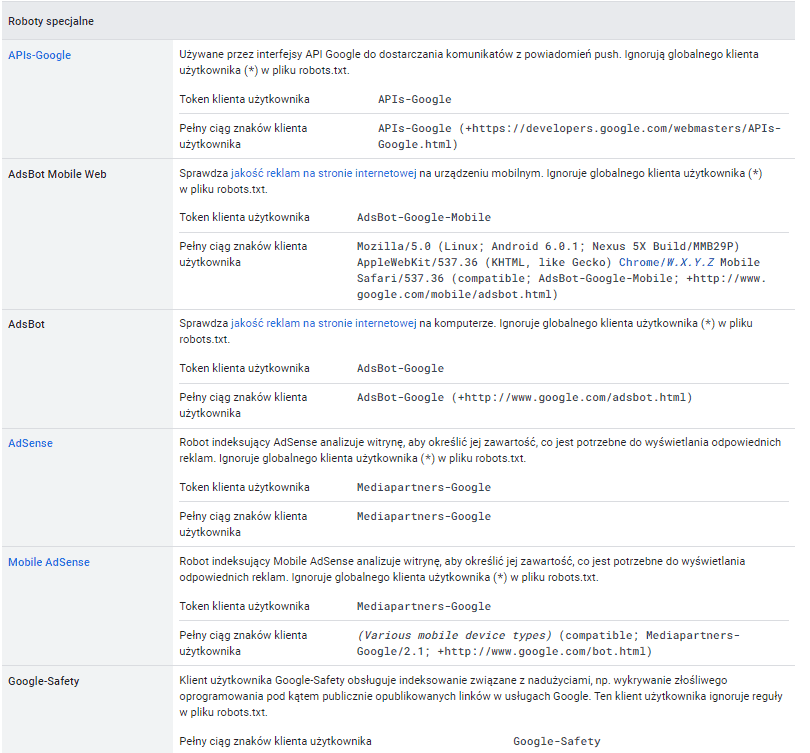

Po naszych stronach poruszają się również roboty specjalne. Według dokumentacji Google mamy ich co najmniej kilka:

Zestawienie robotów specjalnych

(źródło: https://developers.google.com/search/docs/crawling-indexing/overview-google-crawlers?hl=pl)

Roboty Google a pozycjonowanie

Pozycjonowanie stron i roboty Google to elementy nierozłączne. Wspomniany wyżej indeks to nic innego jak ogromna baza danych, w której przechowywane są dane o stronach internetowych. Od jakości tych danych zależy jak wysoko wyświetli się strona internetowa (a więc czy trafimy tam, gdzie szukają nas potencjalni klienci).

Działanie robotów indeksujących

Indeksowanie strony internetowej to proces składający się z 3 kroków. W dużym uproszczeniu są to:

- Skanowanie (crawling) – roboty zaczynają przeszukiwanie od dobrze sobie znanych adresów URL. Śledzą linki, analizują zawartość podstron i identyfikują nowe strony, które pojawiły się od ostatniego crawla. Nowo odkryte podstrony są dodawane do listy do odwiedzenia w przyszłości. Bot nie odwiedza każdej podstrony co crawl – ogranicza w ten sposób zasoby.

- Indeksowanie – po pierwszym etapie Google bot identyfikuje kluczowe elementy na podstronie. Na całkiem nowej stronie jest to zidentyfikowanie pliku robots.txt, w którym zawarte są najważniejsze dla nich informacje.

- Wyświetlanie wyników wyszukiwania – po stworzeniu zapytania przez użytkownika Google zwraca informacje, które według niego najlepiej odpowiadają zapytaniu.

Robot indeksujący i jego odwiedziny na stronie to zatem istotna część tego, czy nasza strona pojawia się w wynikach wyszukiwania, czy też nie. Algorytm Google działa na zasadzie encji i tworzenia relacyjnej bazy danych, w której kataloguje potrzebne informacje.

Zobrazowana relacyjna baza danych (źródło: depositphotos.com)

Jak aktualizacje algorytmów wpływają na pracę robotów i SEO?

Zmiany w algorytmie mogą wprowadzić nowe czynniki rankingowe. Roboty indeksujące będą musiały wziąć pod uwagę inne elementy w czasie skanowania strony internetowej. Aktualizacje algorytmów mogą powodować również zmiany częstotliwości odwiedzania witryn przez roboty. Wpływa to więc na SEO – w trakcie aktualizacji może zmienić się ważność elementów optymalizacyjnych. Pozycjonerzy śledzą więc aktualizacje algorytmów w celu wyciągnięcia tych informacji. Niestety Google nie podaje wszystkich wskazówek – część z nich zależna jest jedynie od spostrzegawczości i doświadczenia SEO-owca.

Praktyczne wskazówki na optymalizację dla robotów Google

Tworzenie skutecznych map stron XML (sitemaps)

Mapy stron XML są nieodzownym narzędziem w optymalizacji SEO, które pomagają robotom Google łatwo zidentyfikować strukturę strony oraz wszystkie jej podstrony. Dobrze zaprojektowana mapa strony powinna zawierać informacje o najważniejszych stronach, aktualizacjach treści oraz priorytetach przy skanowaniu. Automatyczne generowanie i regularne aktualizowanie map strony poprzez narzędzia takie jak Google Search Console lub wtyczki dla CMS (np. Yoast SEO) jest kluczowe dla utrzymania aktualnych informacji o stronie w indeksie Google.

Poprawa szybkości ładowania strony

Szybkość ładowania strony jest nie tylko istotnym czynnikiem dla doświadczeń użytkowników, ale również wpływa na widoczność w wynikach wyszukiwania. Roboty Google priorytetowo traktują szybko ładujące się strony, co wpływa na wyższe pozycje w SERPach (Search Engine Results Pages). Aby poprawić szybkość ładowania strony, można zastosować techniki takie jak kompresja obrazów, optymalizacja kodu HTML/CSS/JavaScript. Narzędzia takie jak Google PageSpeed Insights pomogą zidentyfikować obszary wymagające poprawy oraz rekomendują konkretne działania.

Optymalizacja pliku robots.txt

Plik robots.txt to istotny element zarządzania dostępem robotów do zasobów strony. Poprawnie skonfigurowany plik robots.txt potrafi wyeliminować skanowanie nieistotnych lub duplikujących się treści, co z kolei zwiększa efektywność indeksowania. Należy upewnić się, że ważne strony są dostępne dla robotów, a zasoby takie jak strony administracyjne, strony logowania i zasoby tymczasowe są wyłączone z indeksowania. Regularne testowanie pliku robots.txt za pomocą narzędzi takich jak Google Search Console pomoże wykryć i naprawić potencjalne błędy oraz niezamierzone blokady ważnych zasobów.

Zoptymalizowane linkowanie wewnętrzne

Linkowanie wewnętrzne nie tylko poprawia nawigację dla użytkowników, ale również pomaga robotom Google lepiej zrozumieć strukturę i hierarchię strony. Warto tworzyć logiczne i spójne powiązania pomiędzy stronami, uwzględniając przy tym użyteczność i intencje użytkowników. Upewnij się, że najważniejsze strony posiadają odpowiednią ilość linków wewnętrznych, co wpływa na ich ocenę jako istotnych przez algorytmy wyszukiwarek. Jednolity system nawigacji oraz stosowanie odpowiednich kotwic (anchor text) to kluczowe elementy skutecznego linkowania wewnętrznego, wspomagającego zarówno User Experience, jak i SEO.

Optymalizacja stron internetowych i roboty Google są nierozłącznie związane! (źródło: depositphotos.com)

Roboty indeksujące, algorytmy, pozycjonowanie strony – wykorzystaj je dobrze!

Podsumowując, zrozumienie działania i rodzajów robotów Google jest kluczowe dla efektywnego pozycjonowania strony internetowej. Googleboty, zarówno na smartfony, jak i komputery, oraz specjalizowane roboty skanujące obrazy, wideo czy wiadomości, pełnią niezwykle istotne role w procesie indeksowania i rankingu stron. Aby maksymalnie wykorzystać ich potencjał, warto inwestować w optymalizację strony pod kątem technicznym – od tworzenia skutecznych map XML, przez poprawę szybkości ładowania się strony, po dostosowanie plików robots.txt i linkowanie wewnętrzne. Stale zmieniające się algorytmy Google wymagają również bieżącej analizy i adaptacji strategii SEO.

Pamiętajmy, że dobrze zoptymalizowana strona to nie tylko lepsza widoczność w wynikach wyszukiwania, ale także większa satysfakcja użytkowników, co prowadzi do wyższych wskaźników konwersji. Dbałość o detale techniczne i śledzenie aktualizacji algorytmów to klucz do sukcesu w dynamicznym świecie SEO. Zachęcamy do stałego poszerzania swojej wiedzy oraz śledzenia zmian w algorytmach, co pozwoli na skuteczne reagowanie na nowe wyzwania i maksymalne wykorzystanie narzędzi, które dostarcza nam Google. Dzięki temu Twoja strona będzie nie tylko łatwiej odnajdywana przez użytkowników, ale także będzie spełniała wymagania skomplikowanych mechanizmów wyszukiwarki, stawiając Twoją firmę krok przed konkurencją.